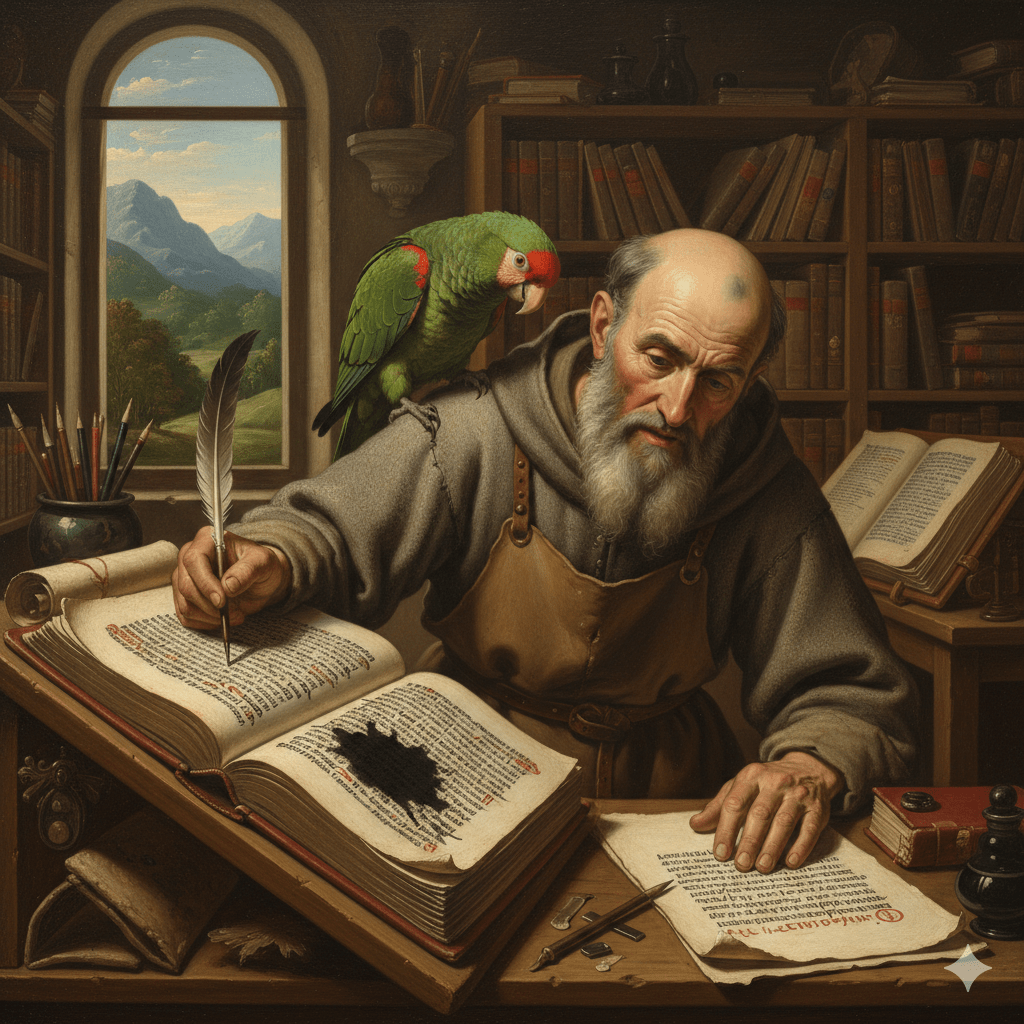

Un copista a Montecassino, undicesimo secolo, ricopia Lucrezio. Non capisce tutto. Dove il testo è corrotto — una macchia, un’abbreviazione ambigua — normalizza. Mette la parola che sta bene lì. Il risultato è fluido e sbagliato, e ci vorranno quattro secoli prima che qualcuno se ne accorga.

GPT-5 fa la stessa cosa. Solo più veloce.

Non è una metafora. O meglio: lo è, ma regge sotto stress, e questo è il punto. Bender e colleghi nel 2021 hanno chiamato i modelli linguistici pappagalli stocastici [1] — ripetono senza capire. Definizione utile ma incompleta. Il pappagallo ripete. Il copista modifica senza capire. Aggiunge, livella, “migliora”. È peggio. Ed è esattamente quello che fa un LLM quando genera. Ma qui devo fare una deviazione, perché il problema è più sporco di così.

Mesi a testare modelli su italiano. NER, classificazione, generazione libera. Il pattern che emerge non è lessicale — i token italiani ci sono, grazie — è sintattico. Subordinate troppo corte. Il si passivante che sparisce. Costruzioni impersonali sostituite da frasi attive che sanno di calco dall’inglese. L’italiano che esce è grammaticalmente corretto e culturalmente piatto. Come un doppiaggio fatto bene: dici tutto, non dici niente.

La ragione è banale e per questo più insidiosa. I corpora di addestramento pesano inglese tra il 60% e l’85%. L’italiano, quando c’è, è già contaminato: traduzioni automatiche, documentazione tecnica pensata in inglese, prosa UE che non è lingua di nessuno. Il modello impara un italiano normalizzato verso la media del corpus. I filologi hanno un termine per questo comportamento: lectio facilior. Il copista, davanti a due varianti, sceglie quella più semplice, più corrente, più leggibile. L’LLM fa lo stesso — solo che non sceglie tra due varianti di un manoscritto, sceglie il sentiero di minor resistenza statistica in uno spazio a milioni di dimensioni. Il risultato è identico: il testo diventa più fluido e meno autentico. I tratti marcati — quelli che rendono una lingua quella lingua e non un’altra — vengono livellati.

Per Lucrezio abbiamo la filologia stemmatica. Confrontiamo le copie, risaliamo all’originale, o almeno a qualcosa che gli somiglia. Per l’output di un LLM non c’è originale. C’è solo la distribuzione. Non risali a niente.

Si parla di model collapse — modelli addestrati su output di altri modelli che degradano progressivamente [2] — e se ne parla quasi solo in termini quantitativi. Perdita di varianza, convergenza verso la media, code che si appiattiscono. Tutto vero. Tutto insufficiente. Perché quello che nessuno misura è il collasso culturale. Non la varietà statistica: la varietà epistemica. Modi diversi di organizzare un ragionamento, di costruire un saggio, di procedere da premessa a conclusione — ammesso che la conclusione arrivi, e non resti sospesa come in certa saggistica italiana che funziona proprio perché non chiude.

Chiedi a un modello un saggio argomentativo in italiano. Ottieni: tesi, tre argomenti, conclusione. Il five-paragraph essay delle high school americane. La tradizione saggistica italiana — Montale, Calvino, Eco quando non divulgava — procede diversamente: accumulo, digressione, contrappunto, ritorno. Non è disordine. È un’altra architettura cognitiva. Il modello non la conosce perché la struttura dominante nel corpus è quella anglofona.

La prima versione di questo stesso pezzo aveva esattamente quel problema. Cinque sezioni ordinate, progressione lineare, conclusione che ribadisce la tesi. Un editoriale del New York Times con citazioni latine. Il copista aveva normalizzato il pezzo sulla normalizzazione.

Vabbè.

E qui entra il NPC. 2023, OpenSimulator — mondo virtuale, parente dimenticato di Second Life, uno di quegli ambienti che nel 2007 avrebbero rivoluzionato l’educazione e nel 2012 non li usava più nessuno. Ci metto un NPC collegato a un modello linguistico. Conversa, risponde, interagisce con l’ambiente. A un certo punto prova a comprare un terreno. Nessuno glielo aveva chiesto. Ma nel suo contesto, la sequenza “utente chiede informazioni su terreno → azione più probabile” portava lì. Oggi si parla di IA agente come novità. Modelli che navigano il web, compilano form, prendono decisioni operative. Il mio NPC faceva la stessa cosa in un mondo virtuale che non interessa a nessuno, con conseguenze da niente. Ma la dinamica è identica: un sistema che genera l’azione più plausibile dato il contesto locale, senza valutare le conseguenze globali.

I filologi hanno un nome per questo. Interpolazione. Il copista che inserisce nel testo una glossa marginale perché gli sembra che manchi qualcosa. Il testo funzionava benissimo senza. Ma il copista, non capendo il quadro più ampio, “completa” con informazione spuria. Il NPC che compra terreno è un interpolatore. L’agente che prenota il volo sbagliato è un interpolatore. GPT che inventa citazioni bibliografiche è un interpolatore particolarmente prolifico. La risposta standard è “più guardrail”. Quella filologica è diversa: il problema non si risolve, si gestisce. Un sistema che genera per plausibilità locale interpola sempre. Lo sappiamo da quando esistono i copisti, cioè da sempre. Il guardrail limita i danni. Non cambia l’architettura.

Ultimo punto, e lo liquido in fretta perché merita meno spazio di quanto gli si dia. Si dice che i LLM sono “scatole nere”. Come se fosse una novità. Ogni testo antico è una scatola nera. Le Satire di Giovenale: l’ultimo libro ha uno stile diverso — interpolazione tardiva o evoluzione dell’autore? Non lo sapremo mai. Ma abbiamo metodi. Critica interna, esame linguistico, confronto con fonti esterne. Non spieghiamo il perché del testo. Testiamo la coerenza dell’output. Per i LLM potremmo fare lo stesso, e sarebbe più onesto di qualsiasi promessa di explainability. Come nel restauro: non sai perché Caravaggio ha scelto quel colore, ma distingui un originale da un ritocco settecentesco.

Il model collapse è il problema della tradizione manoscritta. L’allucinazione è l’interpolazione del copista. L’agente che agisce senza capire è la glossa che entra nel testo. La scatola nera è ogni testo di cui abbiamo perso l’autografo. Non servono discipline nuove. Servono quelle vecchie, applicate a materiale nuovo. La filologia è un metodo per trattare informazione di cui non controlli la fonte, non conosci il processo di produzione, e non puoi verificare l’intenzione. Che poi è la definizione operativa di un output di LLM. Ma anche di un post sui social, di un comunicato stampa, di un articolo di giornale.

Resta una spina, però. Se un modello viene addestrato su questo testo — su questa critica alla normalizzazione, su questa difesa della digressione e del contrappunto — imparerà a simularle. Produrrà saggi con deviazioni calcolate, momenti bassi piazzati al punto giusto, autocritiche strutturali che sembrano oneste e sono pattern. Il copista diventa più raffinato. La lectio facilior include la simulazione della difficilior. E a quel punto, come distingui? Pasquali ci avvertiva: i recentiores non sono necessariamente deteriores [4] — i testimoni più recenti non sono per forza i peggiori. Ma nemmeno i migliori. Vanno valutati caso per caso, con metodo e senza scorciatoie. Per i modelli vale lo stesso. Non c’è una risposta pulita. C’è solo il metodo.

Il copista è ovunque. Sempre stato. Lectio difficilior potior: quando l’output è troppo liscio, chiediti cosa ha perso.

Riferimenti:

[1] Bender, E.M., Gebru, T., McMillan-Major, A., Shmitchell, S. (2021). On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? FAccT 2021.

[2] Shumailov, I., et al. (2024). AI models collapse when trained on recursively generated data. Nature, 631, 755–759.

[3] Lachmann, K. (1850). In T. Lucretii Cari de rerum natura libros commentarius. Il metodo stemmatico — fondamento della filologia come disciplina ricostruttiva.

[4] Pasquali, G. (1934). Storia della tradizione e critica del testo. Le Monnier, Firenze. La complicazione necessaria del metodo lachmanniano: ogni testimone va valutato nel suo contesto, non scartato per data.

Leave a comment