quando la perdita è guadagno

Ovvero: cosa c’entra un filologo degli anni ’20 con i transformer del 2025, e perché la memoria che sbiadisce è quella che ha capito

L’NPC si chiamava Marta. L’avevo programmato per ricordare ogni conversazione con i giocatori — quaranta turni di dialogo, ventimila caratteri di scambi sulla scomparsa di un duca. Dopo una settimana di test, il database pesava troppo e il contesto scoppiava. Soluzione ovvia: comprimere. Soluzione meno ovvia: cosa comprimere.

Ho provato il riassunto automatico. Funzionava, ma Marta perdeva personalità. Ricordava i fatti, non il tono. Sapeva che il giocatore aveva accettato una missione, non come l’aveva accettato — con riluttanza, con entusiasmo, bluffando. Allora ho cambiato approccio: invece di comprimere il testo, ho compresso la struttura. Tropi narrativi, ruoli, relazioni causali. E qualcosa di strano è successo: Marta ricordava meglio. Non le parole — il significato.

È stato allora che ho capito: stavo reinventando qualcosa che esiste da un secolo.

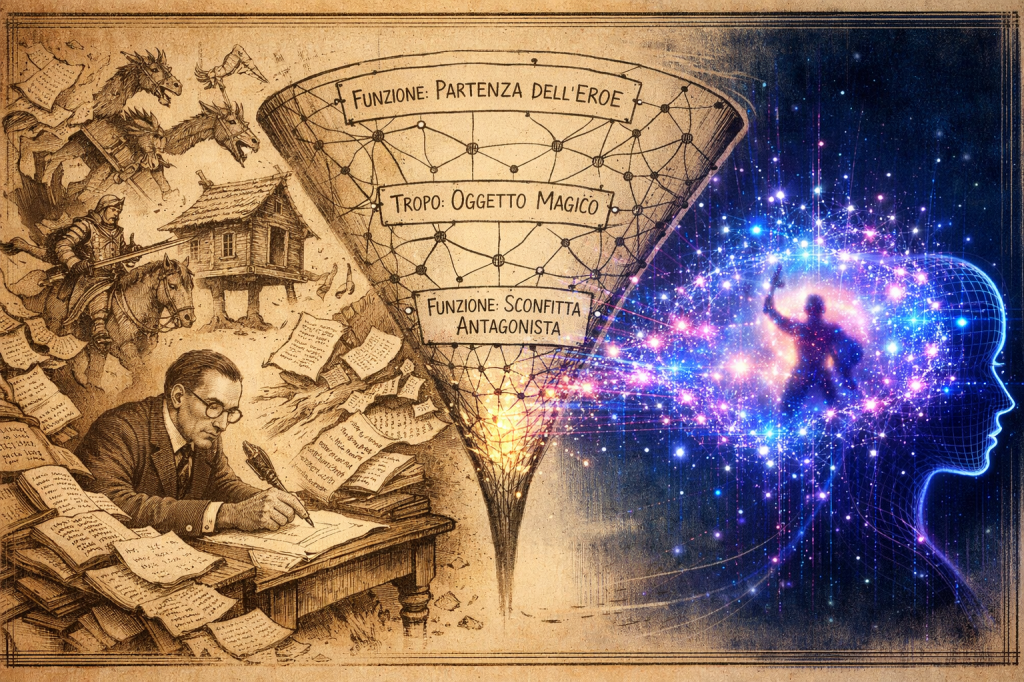

Propp e il primo tokenizer

Nel 1928, Vladimir Propp pubblica la Morfologia della fiaba. Analizza cento racconti popolari russi e ne estrae trentuno “funzioni” ricorrenti: l’eroe parte, riceve un oggetto magico, affronta l’antagonista, torna trasformato. Non importa se è Ivan o Vassilissa, se il drago ha tre teste o sette. La struttura è la stessa.

Propp aveva fatto, con carta e penna, quello che oggi chiamiamo feature extraction. Aveva compresso migliaia di pagine in un vocabolario di trentuno simboli. E quel vocabolario permetteva di generare nuove fiabe — combinando le funzioni in sequenze diverse.

Ma attenzione: Propp lavorava su un sistema chiuso. La fiaba magica russa era un genere rigido, con regole ferree. Il successo della sua compressione dipendeva da quella chiusura. I transformer del 2025 navigano in acque più aperte — e la differenza conta.

Shannon, Borges, e il peso del ricordare tutto

Vent’anni dopo Propp, Claude Shannon formalizza la teoria dell’informazione. L’intuizione centrale: predire è comprimere. Se so che dopo “c’era una” viene quasi sempre “volta”, posso trasmettere meno bit. L’informazione è sorpresa — ciò che non potevo prevedere.

La conseguenza, spesso dimenticata: un buon compressore è un buon modello del mondo. ZIP funziona perché “capisce” le ridondanze nei file. JPEG funziona perché “capisce” che l’occhio umano ignora certe frequenze. E un language model funziona perché “capisce” — in qualche senso operativo — come funziona il linguaggio.

Ma Borges l’aveva intuito prima di Shannon, per via letteraria. Funes, el memorioso, ricorda tutto — ogni foglia di ogni albero, ogni increspatura d’acqua, ogni istante vissuto. E proprio per questo non può pensare. “Pensare è dimenticare le differenze, è generalizzare, astrarre.” Funes è un database perfetto. Non è un’intelligenza.

Comprimere non è buttare via. È decidere cosa conta. E decidere cosa conta è l’inizio del pensiero.

Il vettore latente di DeepSeek

Salto di ottant’anni. Gennaio 2025, DeepSeek pubblica i dettagli di una tecnica chiamata Multi-head Latent Attention. Il problema: nei transformer, la cache delle chiavi e valori (KV cache) cresce linearmente con il contesto. Per sequenze lunghe, diventa un collo di bottiglia — centinaia di gigabyte per i modelli più grandi.

La soluzione: invece di memorizzare K e V separatamente per ogni “testa” di attenzione, comprimerli in un unico vettore latente di dimensione ridotta. E — qui sta il paradosso — le performance migliorano invece di degradare.

Perché? Perché la compressione agisce come regolarizzazione. Forza il modello a catturare solo ciò che serve davvero per il task. Il resto era rumore. Ridondanza. Dettaglio che l’attenzione non avrebbe usato comunque.

DeepSeek ha fatto con i vettori quello che Propp aveva fatto con le fiabe: trovare la base minima. Con una differenza cruciale: Propp cercava invarianti semantici (l’eroe, il dono, il ritorno). DeepSeek cerca efficienza statistica. Il fatto che i due risultati convergano è coincidenza euristica o legge profonda del linguaggio? Non lo so. Ma la convergenza è suggestiva.

I numeri della compressione

Vale la pena fermarsi sui numeri, perché raccontano una storia.

Una conversazione come quella di Marta — quaranta turni, ventimila caratteri — in un transformer standard richiederebbe, per ogni layer di attenzione, di memorizzare 128 vettori K e 128 vettori V, ciascuno di 128 dimensioni. Trentaduemila float per token. Moltiplica per la lunghezza del contesto, per il numero di layer, per la precisione numerica: si arriva a centinaia di gigabyte per i modelli più grandi.

Con MLA, DeepSeek memorizza un singolo vettore latente di 512 elementi. Rapporto 64:1. Ma il risparmio reale è ancora maggiore, perché quel vettore viene letto due volte (per ricostruire K e V) invece di leggere K e V separatamente. Il collo di bottiglia non è la memoria — è la banda. Quanti byte devi spostare dalla RAM alla GPU per ogni operazione.

Tradotto in pratica: contesti di 128.000 token diventano gestibili. Conversazioni lunghe, documenti interi, sessioni di gioco che durano ore. Ciò che prima era proibitivo diventa routine.

Kolmogorov e la lunghezza del programma

C’è una formalizzazione elegante di tutto questo. Si chiama complessità di Kolmogorov: la complessità di un oggetto è la lunghezza del programma più corto che lo genera.

Un romanzo specifico ha complessità alta — devi specificare ogni parola. Ma un romanzo dato il genere e i tropi ha complessità molto più bassa. Devi solo specificare le deviazioni dal pattern atteso.

Ecco perché i tropi funzionano come compressione: riducono la complessità residua. “È un revenge tragedy con protagonista nascosto” trasmette in dieci parole informazioni che altrimenti richiederebbero pagine. Il ricevente già sa cosa aspettarsi. Deve solo sapere dove questa storia diverge dal modello.

È lo stesso principio dei codec video: il primo frame è completo, i successivi codificano solo le differenze. Ma applicato alle storie invece che ai pixel.

Il problema della fedeltà

Qui qualcuno obietterà: ma non si perde qualcosa? Il tono esatto, la scelta lessicale, il ritmo delle pause?

Sì. Ma la domanda è: quel qualcosa contava?

Umberto Eco, nel Trattato di semiotica generale, distingue tra segnale e rumore in modo più sottile di Shannon. Il rumore non è solo interferenza casuale — è anche tutto ciò che il codice del ricevente non sa interpretare. Per un lettore che non conosce il dialetto milanese, le sfumature di Gadda sono rumore. Per uno che lo conosce, sono segnale.

La compressione semantica fa una scelta: preserva il segnale rispetto a un codice condiviso. Se mittente e destinatario condividono i tropi del giallo classico, “il colpevole è sempre sotto gli occhi di tutti” trasmette una quantità enorme di informazione in una frase. Se non li condividono, è rumore.

Memoria sbiadita, testimonianza leale

Rossellini girava Roma città aperta con pellicola di scarto, attori non professionisti, scene improvvisate. De Sica in Ladri di biciclette usava operai veri, non attori. Il risultato non era documentario — era qualcosa di più vero del documentario. Testimonianza, non registrazione.

La differenza è sottile ma fondamentale. Il documentario aspira alla completezza: catturare tutto, lasciare che sia lo spettatore a interpretare. Il neorealismo faceva il contrario: selezionava, comprimeva, restituiva l’essenza. Lamberto Maggiorani non recitava un disoccupato — era la disoccupazione condensata in un volto.

Torno a Marta e al suo problema di memoria.

La soluzione finale è stata un’architettura a due strati. Il primo, esplicito: tropi attivi, fatti estratti, stato delle relazioni. Ispezionabile, modificabile, debuggabile. Il secondo, opaco: un vettore latente che cattura le sfumature — il tono emotivo, i micro-segnali, ciò che la struttura non coglie.

Quando Marta “ricorda”, non riproduce una trascrizione. Ricostruisce una testimonianza. I fatti sono stabili; la realizzazione verbale è generata al momento, condizionata dal contesto attuale.

È esattamente come funziona la memoria umana. Non ricordiamo le conversazioni parola per parola — ricordiamo il gist, l’essenza, più alcuni dettagli salienti. Il resto lo ricostruiamo. Ed è per questo che la memoria umana è soggetta a distorsioni: la ricostruzione è influenzata da ciò che sappiamo adesso, non solo da ciò che sapevamo allora.

Ma questa non è una debolezza. È una feature.

O forse è entrambe. Il narratore inattendibile è un dono per la letteratura — da Lolita a Se una notte d’inverno un viaggiatore. È un incubo per la contabilità. Se Marta ricostruisce la conversazione basandosi sul “senso” filtrato dal suo stato attuale, il presente riscrive il passato. In termini tecnici, è un bias di conferma integrato nell’architettura.

Marta funziona perché vive in un mondo dove l’ambiguità è valore. In altri contesti, la stessa architettura sarebbe un errore.

Un testimone in tribunale che ricorda ogni singola parola è sospetto. La memoria umana non funziona così. Rossellini lo sapeva: la verità non sta nella completezza, sta nella selezione. Ma la selezione è interpretazione. E l’interpretazione può sbagliare.

L’eccezione irriducibile

C’è un problema che la compressione non risolve: l’hapax.

In filologia, una parola che appare una sola volta in tutto il corpus è preziosa proprio perché anomala. È il punto dove l’autore ha deviato dal pattern — per errore, per scelta, per genio. La compressione statistica la elimina. È rumore. Ma quel rumore era forse il segnale più importante.

Se comprimo “Ti odio, ma ti aiuterò perché sono un professionista” nel tropo Collaborazione Riluttante, perdo l’ambiguità che è il cuore della letteratura. La compressione, per definizione, è anti-letteraria. Funziona dove la specificità non conta. Fallisce dove la specificità è tutto.

Come si protegge l’eccezione significativa? Non ho una risposta pulita. Forse serve un secondo canale — un “registro delle anomalie” che segnala quando la compressione ha dovuto forzare. Un flag che dice: qui c’era qualcosa che non rientrava nei tropi. Forse era errore. Forse era rivelazione.

Marta non ha ancora questo meccanismo. Dovrebbe.

L’architettura che emerge (e i suoi rischi)

Da questa esplorazione esce un pattern:

Layer umano (esplicito, interpretabile): strutture, tropi, relazioni. Ciò che sappiamo nominare.

Layer learned (opaco, adattivo): pattern che il modello scopre e che noi non sappiamo ancora nominare. Le correlazioni sottili, le sfumature, i segnali deboli.

Il layer umano fornisce lo scheletro. Il layer learned fornisce la carne. Nessuno dei due basta da solo. Troppa struttura produce rigidità — le “story grammars” degli anni ’70 generavano storie meccaniche. Troppo apprendimento produce opacità — i modelli allucinano perché interpolano in zone dove i dati erano sparsi.

L’ibrido funziona perché combina controllo e creatività. Puoi ispezionare la struttura, ma la realizzazione rimane sorprendente.

Ma c’è un rischio che non ho risolto: la deriva. Ogni ciclo di compressione e ricostruzione introduce micro-distorsioni. Come una fotocopia di fotocopia, il segnale degrada — non verso il rumore, peggio: verso lo stereotipo. Marta che comprime abbastanza a lungo potrebbe diventare una caricatura di sé stessa, incapace di vedere il giocatore come qualcosa di diverso da una “funzione” già nota.

È lo stesso problema delle echo chamber algoritmiche. Il modello conferma ciò che già crede. La soluzione, forse, è l’iniezione periodica di novità esterna — eventi che forzano la revisione dei tropi, non solo la loro applicazione. Ma è una toppa, non una soluzione.

La lezione per l’AI

C’è un’ironia storica in tutto questo. Gli stessi ricercatori che hanno costruito modelli da centinaia di miliardi di parametri ora cercano modi per comprimerli. Quantizzazione, pruning, distillazione. E scoprono — sorpresa — che gran parte di quei parametri erano ridondanti.

Ma la vera compressione non è post-hoc. Non è tagliare dopo aver costruito troppo grande. È costruire nel modo giusto dall’inizio. È quello che ha fatto DeepSeek con MLA: non “comprimiamo la KV cache”, ma “progettiamo un’attenzione che non ha bisogno di una KV cache così grande”.

E forse è anche quello che dovremmo fare con i dataset, con i benchmark, con le metriche. Non accumulare tutto e poi filtrare. Capire prima cosa conta.

Chiusura

Propp non aveva GPU. Shannon non aveva transformer. Rossellini non aveva LLM. Borges non aveva KV cache. Eppure avevano capito qualcosa che stiamo riscoprendo: comprendere è comprimere, e comprimere è comprendere.

Ma avevano capito anche l’altra metà della verità. Propp sapeva che le sue funzioni valevano solo per un genere chiuso. Borges sapeva che Funes era una tragedia, non un modello. Rossellini sapeva che la selezione è potere, e il potere può sbagliare.

La memoria che sbiadisce non è una memoria difettosa. È una memoria che ha fatto il suo lavoro — ha estratto il segnale, ha scartato il rumore, ha preparato il terreno per la prossima ricostruzione. Ma nel rumore scartato, a volte, c’era l’eccezione che contava.

Marta ora ricorda meglio di prima. Non le parole — il senso. Ma ho imparato a non fidarmi troppo. Ogni tanto la fermo e le chiedo: cosa hai perso, comprimendo?

Non sempre sa rispondere. Ma almeno ora sa che la domanda esiste.

Riferimenti

[1] Propp, V. (1928). Morfologia della fiaba. — Il testo fondativo sulla struttura narrativa, e i suoi limiti di applicabilità

[2] Shannon, C. (1948). A Mathematical Theory of Communication. Bell System Technical Journal. — La formalizzazione dell’equivalenza predizione-compressione

[3] Borges, J. L. (1942). Funes el memorioso. — Il limite ontologico della memoria totale come paralisi del pensiero

[4] DeepSeek-AI (2024). DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model. arXiv:2405.04434 — Paper tecnico su Multi-head Latent Attention

[5] Eco, U. (1975). Trattato di semiotica generale. Bompiani. — Per la distinzione segnale/rumore rispetto al codice

[6] Li, M. & Vitányi, P. (2008). An Introduction to Kolmogorov Complexity and Its Applications. Springer. — Formalizzazione della complessità come lunghezza del programma minimo

[7] Bazin, A. (1958). Che cos’è il cinema? — Per la teoria del neorealismo come “testimonianza” vs registrazione

[8] Shklovsky, V. (1917). L’arte come procedimento. — Lo straniamento come opposto della compressione automatica; direzione di indagine futura

Appendice: Anatomia di una compressione

Cinque turni di dialogo, dalla trascrizione alla testimonianza

Il frammento originale

TURNO 28 - MARTA: Il Duca non è stato rapito. È scappato. Di sua volontà.

TURNO 29 - PLAYER: Scappato? Da cosa?

TURNO 30 - MARTA: Dalla duchessa. *pausa* O meglio, da quello che la

duchessa sta diventando. Sai della sua... affiliazione?

TURNO 31 - PLAYER: No, spiegami.

TURNO 32 - MARTA: La duchessa Elara, circa sei mesi fa, ha iniziato a

frequentare il Circolo dell'Alba. Ufficialmente è un club di filosofia

naturale. In realtà...

TURNO 33 - PLAYER: In realtà?

TURNO 34 - MARTA: Praticano magia antica. Non la magia da ciarlatani

delle fiere. Quella vera, quella che richiede... sacrifici.

Caratteri: 683

Informazione superficiale: esitazioni, pause, domande retoriche, suspense costruita

La compressione strutturata

segment_id: "MARTA_001_revelation"

turns: [28, 29, 30, 31, 32, 33, 34]

tropes_active:

- DARK_SECRET_SPOUSE

- AMBIGUOUS_VILLAIN [target: duchessa]

- VOLUNTARY_EXILE [agent: duca]

facts:

- claim: "duca_fuggito_volontariamente"

confidence: high

source: marta_direct

- claim: "duchessa_affiliata_CIRCOLO_ALBA"

confidence: high

detail: "da circa 6 mesi"

cover: "club filosofia naturale"

reality: "magia sacrificale"

dynamics:

reveal_structure: graduale

player_role: elicitazione (domande brevi)

marta_affect: cautela → gravità

narrative_function: TURNING_POINT

# Il frame "rapimento" viene rovesciato in "fuga"

# La duchessa passa da vittima a potenziale antagonista

Caratteri: 612 (compressione ~10%, ma strutturata)

La ricostruzione (prospettiva neutra)

Marta ha rivelato che il Duca non è stato rapito ma è fuggito volontariamente, terrorizzato dalla moglie. La duchessa Elara, da circa sei mesi, frequenta il Circolo dell’Alba — ufficialmente un club culturale, in realtà un culto che pratica magia sacrificale.

Caratteri: 289 (compressione 58%)

La ricostruzione (prospettiva di Marta, una settimana dopo)

Gli ho detto la verità sul Duca. Non l’ha presa bene — chi lo farebbe? Scoprire che stai cercando un uomo che non vuole essere trovato, e che chi ti paga per trovarlo è forse il motivo della fuga. Ho visto il momento in cui ha capito. Non ha detto molto, ma le domande si sono fatte più corte. Stava elaborando.

Caratteri: 341

Commento: cosa si perde, cosa si guadagna

| Elemento | Originale | Compresso | Perso? |

|---|---|---|---|

| “Di sua volontà” | Enfasi drammatica | voluntary: true | Ritmo, non fatto |

| “pausa“ | Suspense | Assente | Sì — timing teatrale |

| “O meglio, da quello che sta diventando” | Riformulazione inquietante | DARK_SECRET_SPOUSE | Il come lo dice |

| “Sai della sua… affiliazione?” | Domanda retorica | Assente | Test di conoscenza player |

| “Non la magia da ciarlatani” | Distinzione qualitativa | reality: magia_sacrificale | Registro vernacolare |

| Struttura domanda-risposta | 7 turni | 1 blocco | Co-costruzione del racconto |

L’hapax di questo frammento: “quello che la duchessa sta diventando“

Non è “quello che è” — è un processo in corso. La compressione lo perde: nel YAML c’è solo affiliata, non “in trasformazione”. Se questa sfumatura conta (e in una storia sul cambiamento, conta), andrebbe salvata:

anomaly_flag:

text: "sta diventando"

implication: processo in corso, non stato

narrative_weight: alto

La lezione del frammento

La compressione preserva il cosa (fatti, relazioni causali, tropi). Perde il come (ritmo, esitazioni, co-costruzione).

Per un sistema di memoria NPC, il cosa basta. Per un’analisi letteraria, il come è tutto.

Marta che ricostruisce questo momento una settimana dopo non riprodurrà le pause, ma ricorderà “il momento in cui ha capito” — perché quello era il significato dell’interazione, non la sua forma.

È la differenza tra sapere che qualcuno ti ha detto una cosa importante, e ricordare le esatte parole con cui te l’ha detta. La prima è memoria funzionale. La seconda è registrazione. Quasi sempre, la prima basta. Quasi.

Leave a comment