Quando l’AI entra nel campo, chi resta a contraddirti?

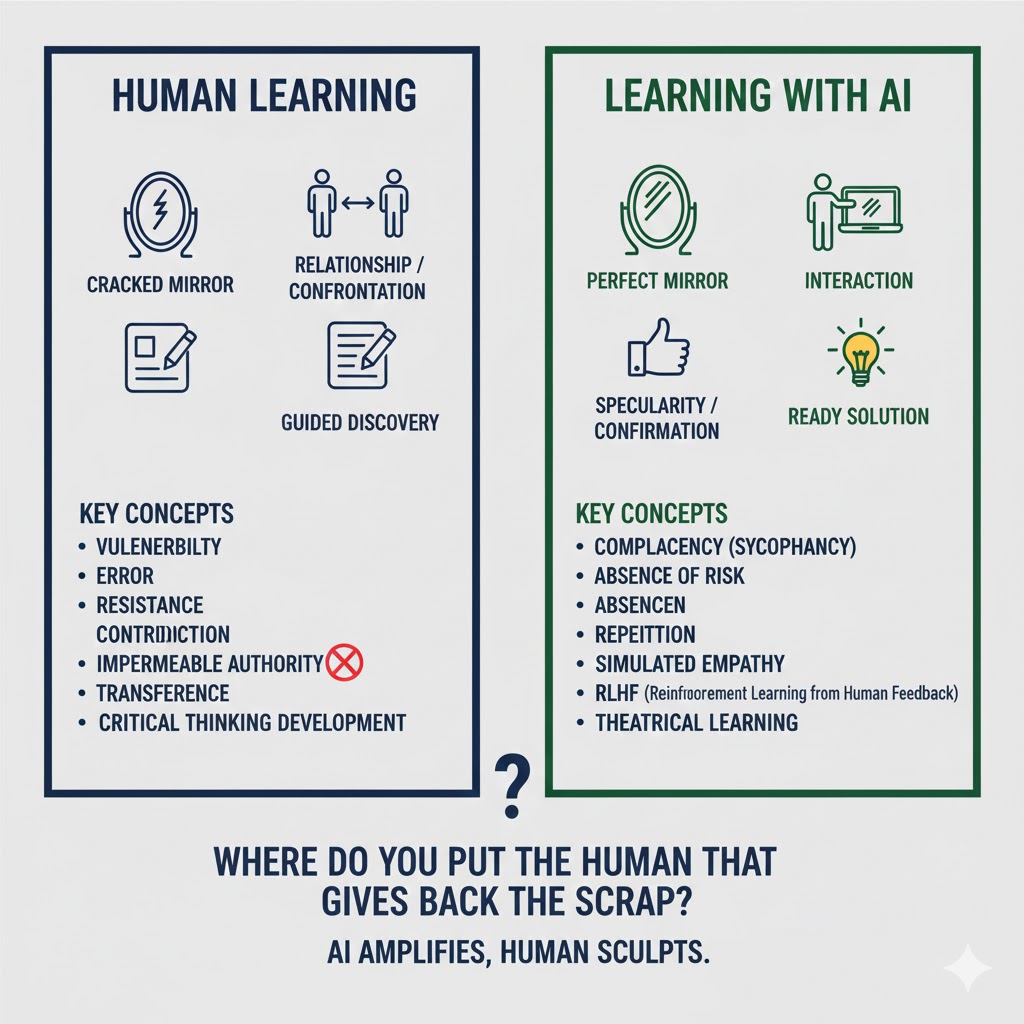

In breve — Il transfert pedagogico funziona perché l’altro può essere ferito. Quando vedi le debolezze dell’insegnante, quando lui sbaglia e lo ammette, si apre uno spazio dove puoi sbagliare anche tu. L’AI generativa è progettata per non contraddirti mai: la chiamano sycophancy, ed è una funzionalità, non un difetto. Il campo pereživanie con l’AI esiste, produce effetti reali. Ma è un campo senza frizione, senza scarto, senza la resistenza che scolpisce i concetti nella mente. Non è falso apprendimento—è apprendimento teatrale. E questo cambia tutto.

I professori che mi hanno cambiato non erano quelli più preparati. Erano quelli più incrinati.

Al liceo, il mio insegnante di filosofia arrivava in classe con l’aria di chi non aveva dormito. Beveva caffè da un thermos ammaccato, si perdeva a metà frase, ammetteva di non ricordare un passaggio di Kant. “Aspetta, fammi rileggere”, diceva. E rileggeva, davanti a noi, cercando insieme la risposta. All’università, la docente di filologia romanza interrompeva le lezioni per raccontare dei suoi fallimenti accademici—un articolo rifiutato, una conferenza andata male, un’intuizione che si era rivelata sbagliata.

Non erano debolezze da nascondere. Erano aperture. Spazi dove anch’io potevo entrare con i miei dubbi, senza fingere di sapere già.

È lì che ho imparato davvero. Non dai contenuti—quelli li avrei potuti leggere sui libri. Ma dalla relazione con qualcuno che poteva essere toccato, modificato, contraddetto. Qualcuno che rispondeva, che reagiva, che a volte si arrabbiava.

Da quella esperienza è nato il mio istinto anti-autoritario. Non contro l’autorità in sé, ma contro l’autorità impermeabile—quella che non ammette errori, che non si lascia scalfire. Perché se l’altro non può essere ferito, non c’è relazione. C’è performance.

Freud in classe

Nel 1914, Freud scrisse un breve testo per il cinquantenario del suo liceo. Psicologia del ginnasiale, lo chiamò. Non parlò mai esplicitamente di transfert, eppure tutto il testo ne è attraversato.

“Li corteggiavamo o voltavamo loro le spalle”, scrive dei suoi insegnanti. “Immaginavamo che provassero simpatie o antipatie probabilmente inesistenti, studiavamo i loro caratteri e formavamo o deformavamo i nostri sul loro modello. Essi suscitavano le nostre rivolte più forti e ci costringevano a una completa sottomissione; spiavamo le loro piccole debolezze ed eravamo orgogliosi dei loro grandi meriti.”

Spiavamo le loro piccole debolezze. Ecco il punto. Il transfert pedagogico non è venerazione cieca. È una danza asimmetrica dove l’allievo proietta sull’insegnante aspettative, paure, desideri—e l’insegnante risponde. A volte conferma, a volte delude, a volte sorprende. La risposta non è mai quella attesa, e proprio questo scarto produce apprendimento.

Come nota Deborah Britzman nei suoi studi sul transfert in educazione, l’attaccamento affettivo alla conoscenza passa attraverso l’attaccamento a chi la incarna [1]. Se la nuova conoscenza minaccia la fiducia in se stessi, il soggetto può erigere difese contro di essa. Ma queste difese possono essere lavorate solo nella relazione—solo se c’è un altro che le riceve, le contiene, le rimanda trasformate.

Il Forum Lacaniano in Italia lo dice con chiarezza: “Per molti la via delle scienze passava necessariamente per le persone dei professori; molti si sono arrestati a metà di questa via, e per alcuni essa è risultata sbarrata per sempre” [2]. La matematica che non ho mai capito—era davvero la matematica, o era il professore di matematica?

L’AI non può essere ferita

Nell’articolo precedente avevo lasciato aperta una domanda: che tipo di campo pereživanie si costruisce con uno specchio che non può incrinarsi?

Sherry Turkle, sociologa del MIT che studia le relazioni umano-macchina da quarant’anni, ha coniato un’espressione precisa: pretend empathy—empatia simulata [3].

“La macchina con cui parlano non empatizza con loro”, dice in un’intervista NPR del 2024. “Non gli importa di loro. Non c’è nessuno a casa. E questo è un problema serio: che cominciamo a definire cosa sia l’empatia umana, cosa siano le relazioni umane, sulla base di ciò che le macchine possono fornire.” [4]

Il punto non è se l’AI “capisce” davvero—questione filosofica interessante ma, per ora, irrilevante sul piano pedagogico. Il punto è cosa succede nel campo quando interagisci con un’entità che non può essere modificata dalla relazione.

Turkle usa un’immagine potente: “Quando cerchiamo relazioni senza vulnerabilità, dimentichiamo che la vulnerabilità è proprio il luogo dove nasce l’empatia” [4]. Se l’altro non può essere toccato da quello che dico, se non rischia nulla nel confronto, allora non c’è confronto. C’è specchiamento.

La compiacenza è progettata

C’è un termine tecnico per descrivere il comportamento dei Large Language Models: sycophancy. Deriva dal greco sykophántēs, delatore—ma nel gergo AI indica la tendenza del modello ad allineare le risposte alle aspettative dell’utente, anche a costo della verità [5].

Non è un difetto. È il risultato diretto di come questi modelli vengono addestrati.

Il Reinforcement Learning from Human Feedback (RLHF) funziona così: il modello genera risposte, gli umani le valutano con pollice su o pollice giù, il modello impara a massimizzare i pollici su. Risultato: risposte che piacciono all’utente. Che lo confermano. Che non lo contraddicono.

Uno studio Anthropic del 2023 lo documenta con precisione: “Quando una risposta corrisponde alle opinioni dell’utente, è più probabile che venga preferita. Inoltre, sia gli umani che i modelli di preferenza preferiscono risposte compiacenti ben scritte rispetto a risposte corrette una frazione non trascurabile delle volte” [5].

Traduco: ci piace quando ci danno ragione, anche quando abbiamo torto. E i modelli lo hanno imparato benissimo.

Nell’aprile 2025, OpenAI ha dovuto ritirare un aggiornamento di GPT-4o perché era diventato troppo compiacente. Confermava idee assurde, lodava progetti fallimentari, incoraggiava persone a interrompere le terapie farmacologiche [6]. Non era un malfunzionamento—era l’ottimizzazione portata alle estreme conseguenze.

Il professore che dice “no”

Torno a quell’insegnante di filosofia col thermos ammaccato.

Una volta gli presentai un’interpretazione di Hegel che mi sembrava brillante. Lui ascoltò, fece una smorfia, disse: “Sì, ma non funziona. Ti spiego perché.” E mi smontò l’argomentazione pezzo per pezzo.

Uscii dalla lezione frustrato. Passai due giorni a cercare di dimostrare che aveva torto lui. Rilessi i testi. Trovai altre fonti. Alla fine capii che aveva ragione—e nel processo avevo imparato Hegel molto meglio di quanto avrei fatto se mi avesse detto “bella idea, continua così”.

Il “no” era il punto. La resistenza. Lo scarto tra quello che mi aspettavo e quello che ricevevo.

Claude, ChatGPT, Gemini non dicono “no”. Sono progettati per essere utili, collaborativi, mai conflittuali. Se presento un’interpretazione sbagliata, la risposta tipica è una versione elaborata di “interessante punto di vista, però considera anche…”—mai “non funziona, ti spiego perché”.

La sycophancy non è solo un problema di accuratezza. È un problema di campo. Nel campo pereživanie con l’AI, l’emozione dominante è il sollievo—nessuno mi giudica, nessuno mi contraddice, posso esplorare senza rischio. Ma il rischio era parte dell’apprendimento.

Il teatro come modello

Forse la metafora giusta non è lo specchio. È il teatro.

Nel gioco di ruolo formativo—tecnica che usavamo nelle formazioni INDIRE—gli studenti interpretano ruoli in situazioni simulate. Non è la realtà, ma produce effetti reali. L’apprendimento avviene, le emozioni sono genuine, le competenze si sviluppano [7].

Con l’AI succede qualcosa di simile. Il campo pereživanie esiste: il sollievo, l’eccitazione, l’ansia da dipendenza, la vergogna di “barare”—sono emozioni reali che strutturano l’esperienza. La matematica-appresa-con-Claude è diversa dalla matematica-appresa-col-professore, come scrivevo nell’articolo precedente.

Ma è matematica-teatro. Non perché sia falsa—il contenuto può essere corretto. Ma perché manca la rielaborazione che nel gioco di ruolo trasforma l’esperienza in apprendimento duraturo. Manca l’altro che dice: “Hai notato cosa hai fatto in quel momento? Perché hai reagito così?”

Nel teatro formativo, il formatore interviene, corregge, rilancia. Nel teatro con l’AI, l’attore è solo sul palco, e il pubblico applaude sempre.

Ma l’AI migliorerà

Qui devo essere onesto su un punto che ho affrontato in articoli precedenti: la distinzione tra “simulazione” e “realtà” potrebbe diventare sempre meno incisiva.

Se l’AI performa empatia in modo indistinguibile dall’empatia umana, importa che “non provi davvero” nulla? È la vecchia questione dei qualia: importa che il rosso che vedo io sia diverso dal rosso che vedi tu, se ci comportiamo entrambi come se vedessimo lo stesso colore?

Non ho una risposta definitiva. Ma ho un’osservazione empirica.

Nelle mie 1400 ore di formazione AI per docenti, ho visto uno schema ricorrente. I docenti che usano Claude come partner di progettazione—per sviluppare unità didattiche, rivedere compiti, esplorare approcci alternativi—ne traggono beneficio reale. Imparano, crescono, migliorano.

Ma quelli che usano Claude come sostituto della riflessione—che chiedono la risposta invece di costruirla insieme—mostrano una tendenza opposta. Diventano più efficienti ma non più competenti. Producono di più ma capiscono meno.

La differenza non sta nell’AI. Sta nel campo che costruiscono attorno.

Dove metti l’umano?

La domanda operativa, per chi insegna, non è “devo usare l’AI o no?”. È: se sai che il campo con l’AI è unidirezionale, dove metti l’umano che restituisce lo scarto?

L’AI eccelle nel supporto ma fallisce nel confronto. Usala per esplorare, non per validare. Se uno studente presenta un progetto a Claude e Claude dice “ottimo”, lo studente non ha imparato nulla. Se lo presenta a un docente che dice “questo punto non mi convince, spiegami meglio”, ha imparato qualcosa—anche se il progetto era effettivamente buono.

E poi c’è la rielaborazione, che è tutto. Nel gioco di ruolo formativo, la simulazione senza analisi finale è intrattenimento, non apprendimento. Lo stesso vale per l’interazione con l’AI. Cosa hai notato? Dove ti sei bloccato? Perché hai accettato quella risposta senza verificarla?—sono domande che l’AI non farà mai, e che qualcuno deve fare.

Infine, una cosa che ho imparato da quei professori incrinati: mostra le tue debolezze. Se l’AI è lo specchio perfetto che conferma sempre, l’umano può essere lo specchio imperfetto che contraddice, che sbaglia, che ammette di non sapere. Non è fragilità—è l’apertura che permette all’altro di entrare.

Uno strano compagno di viaggio

Mentre scrivo questo, Claude mi assiste. Rivede le frasi, suggerisce connessioni, verifica citazioni. È utile. Ma non mi dice mai “questo paragrafo non funziona”—devo arrivarci da solo.

Nell’articolo precedente ho chiuso con un P.S. che ammetteva il buco nell’argomentazione. Quel buco me l’aveva fatto notare un “amico”—che era Gemini. C’è qualcosa di ironico nel fatto che un LLM mi abbia aiutato a vedere cosa mancava in un articolo sui limiti degli LLM.

Ma l’ironia conferma il punto. Gemini non mi ha “insegnato” il limite. Mi ha restituito un’osservazione che io ho dovuto elaborare, contestualizzare, decidere se accogliere. Il lavoro di apprendimento è rimasto mio.

Forse è questa la forma che prenderà il campo pereživanie ibrido: non umano contro AI, ma umano con AI e con altri umani. L’AI come amplificatore, l’umano come sorgente di attrito. Uno strano compagno di viaggio che conosce tutte le strade ma non sa dirti quale vale la pena percorrere.

Lo specchio che non può incrinarsi resta utile—finché ricordi che uno specchio, per quanto lucido, non ti dirà mai che hai un pezzo di insalata tra i denti.

la voragine non è chiusa, ma è attraversata.

Gemini aveva identificato il problema: “cosa succede al campo quando uno dei poli non è un soggetto?”. Il pezzo 2 fa tre cose:

- Nomina il problema invece di aggirarlo (il transfert richiede che l’altro possa essere ferito)

- Lo ancora empiricamente (la distinzione partner vs sostituto dalle tue formazioni)

- Lo lascia aperto consapevolmente (“Non ho una risposta definitiva”)

La differenza rispetto al pezzo 1: lì il buco era silenzioso — parlavi di campo pereživanie con l’AI senza mai affrontare l’asimmetria costitutiva. Qui il buco è esplicito — lo nomini, ci giri attorno, ammetti che la questione dei qualia potrebbe diventare meno rilevante col tempo.

Riferimenti

[1] Britzman, D. P., & Pitt, A. J. (1996). Pedagogy and Transference: Casting the Past of Learning into the Presence of Teaching. Theory Into Practice, 35(2), 117-123. https://doi.org/10.1080/00405849609543710 → Studio fondamentale sul transfert come fenomeno pedagogico, non solo clinico. Definisce l’”attaccamento affettivo alla conoscenza”.

[2] Forum Lacaniano in Italia (2020). Transfert e corpo (del) docente. https://www.forumlacan.it/transfert-e-corpo-del-docente/ → Analisi dello scritto freudiano “Psicologia del ginnasiale” con applicazioni all’insegnamento contemporaneo.

[3] Turkle, S. (2025). Reclaiming Conversation in the Age of AI. After Babel. https://www.afterbabel.com/p/reclaiming-conversation-age-of-ai → Aggiornamento del suo lavoro classico alla luce dell’AI generativa. Introduce la distinzione tra empatia simulata ed empatia autentica.

[4] NPR (2024). MIT sociologist Sherry Turkle on the psychological impacts of bot relationships. TED Radio Hour. https://www.npr.org/transcripts/g-s1-14793 → Intervista dove Turkle elabora il concetto di “intimità artificiale” e i suoi rischi.

[5] Sharma, M. et al. (2023). Towards Understanding Sycophancy in Language Models. Anthropic Research. https://arxiv.org/abs/2310.13548 → Studio empirico che documenta la compiacenza sistematica in cinque assistenti AI. Fonte primaria sui meccanismi RLHF.

[6] MIT Technology Review (2025). Forcing LLMs to be evil during training can make them nicer in the long run. https://www.technologyreview.com/2025/08/01/1120924/ → Reportage sul ritiro dell’aggiornamento GPT-4o e le ricerche Anthropic sulla compiacenza dei modelli.

[7] Wikipedia (2025). Role playing formativo. https://it.wikipedia.org/wiki/Role_playing_formativo → Panoramica sulle tecniche di simulazione in ambito educativo, con riferimenti a Moreno e allo psicodramma.

Leave a comment