Quando Coleridge incontra l’algoritmo: sulla fede poetica e le sue crepe

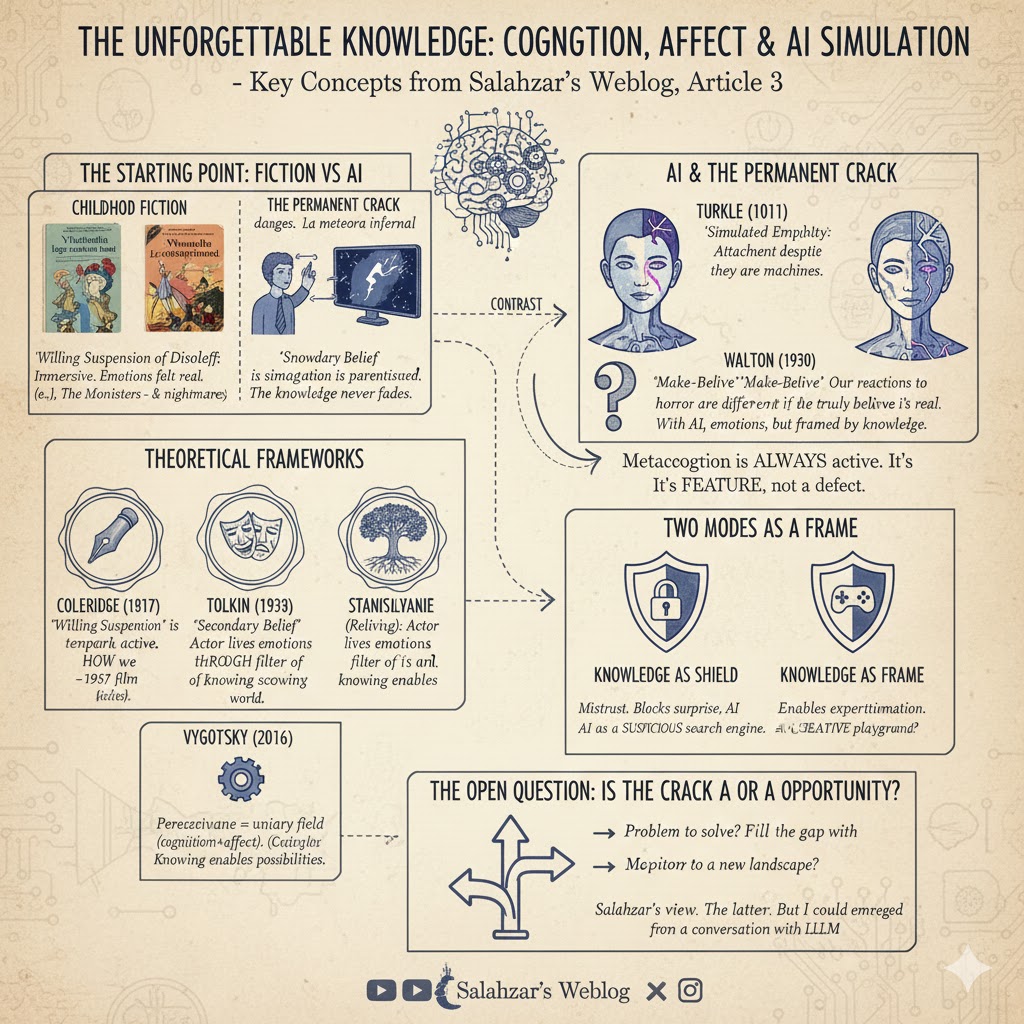

In breve — Cosa cambia quando sai che è simulazione, anche se non riesci a distinguerla? Tutto. La metacognizione non è un accessorio: è parte costitutiva del campo. Coleridge parlava di “sospensione volontaria dell’incredulità”, ma con l’AI il sapere non si sospende mai del tutto. È una crepa permanente nello specchio — e forse è quella crepa a renderlo utile.

Da ragazzo divoravo fantascienza. Verne, Asimov, i classici. Ricordo le notti con Ventimila leghe sotto i mari: il Nautilus era reale, il capitano Nemo esisteva, l’oceano profondo aveva mostri e meraviglie. Non “facevo finta” di crederci — ci credevo, per quelle ore. Il mondo fuori dalla finestra spariva.

C’era un film che mi ossessionava e non mi lasciava dormire: The Monolith Monsters, del 1957 — in Italia uscì come La meteora infernale. Frammenti di meteorite che crescevano a contatto con l’acqua, torri nere che si moltiplicavano all’infinito, persone pietrificate. Scientificamente assurdo. Ma mentre guardavo non m’importava — ero dentro quel terrore, con quei personaggi, a cercare la soluzione. Che poi era acqua salata: fanno saltare una diga per inondare le saline. Geniale nella sua improbabilità.

Quello era il patto: tu racconti bene, io mi lascio trasportare. La mia incredulità si sospendeva davvero — non per ingenuità, ma per scelta. Sapevo che era finzione, ma quel sapere scivolava sullo sfondo, diventava irrilevante. Gli incubi che seguivano erano il prezzo dell’immersione totale.

Con l’AI non funziona così.

Quando parlo con Claude, il sapere non scivola mai sullo sfondo. Resta lì, costante, come un sottotitolo permanente: stai parlando con un modello linguistico. Non dimentico, neanche per un momento. Eppure l’interazione produce effetti — imparo, risolvo problemi, a volte mi sorprendo. Il sapere non blocca l’esperienza. La permea, la modifica dall’interno.

È un tipo di fede diversa. Incrinata fin dall’inizio.

Coleridge aveva ragione (ma non su tutto)

Nel 1817 Samuel Taylor Coleridge coniò una formula diventata moneta corrente: la sospensione volontaria dell’incredulità [1]. L’idea è che di fronte a una narrazione fantastica — spiriti, draghi, marinai maledetti — il lettore accetti temporaneamente di mettere da parte il giudizio critico. Non crede davvero, ma fa come se credesse. È il patto che rende possibile la catarsi.

Coleridge però parlava di un gesto attivo e temporaneo: sospendi, ti immergi, poi riemergi. Il sipario cala, torni alla realtà. E soprattutto: durante l’immersione, il sapere che è finzione passa in secondo piano. Non lo dimentichi, ma lo metti tra parentesi.

Tolkien non era d’accordo. Nel saggio Sulle fiabe propose un concetto diverso: la fede secondaria [2]. Non si tratta di sospendere l’incredulità verso qualcosa che sai falso. Si tratta di credere davvero — ma in un mondo secondario con le sue regole interne. Non fingi di credere agli elfi: credi agli elfi in quel mondo, che ha una coerenza propria.

La differenza è sottile ma importante. Per Coleridge il sapere resta, solo viene messo tra parentesi. Per Tolkien il sapere si sposta su un altro livello: sai che il mondo primario è diverso, ma nel mondo secondario credi genuinamente.

E con l’AI?

La fede che non si chiude mai

Quando parlo con Claude, non sospendo nulla. So che è un modello linguistico. So che le sue risposte emergono da processi statistici. So che non ha esperienza soggettiva — o se ce l’ha, non posso saperlo. Questo sapere non va mai via, neanche per un momento.

Ma interagisco lo stesso. E quell’interazione produce effetti reali: imparo cose, risolvo problemi, a volte mi emoziono. Il sapere non blocca l’esperienza — la permea, la modifica dall’interno.

Sherry Turkle ha lavorato per decenni su questo territorio. In Alone Together parla di “empatia simulata” e nota come i bambini che interagiscono con robot sociali sviluppino attaccamento genuino anche sapendo che sono macchine [3]. Non si illudono: sanno. Ma quel sapere non impedisce il legame. Lo qualifica.

Nel 2016 costruivo personaggi virtuali in OpenSimulator per attività didattiche. Risposte preconfezionate, nessuna vera comprensione. Eppure funzionava: gli studenti interagivano, si impegnavano. La cosa interessante venne dopo, nei riscontri. Una ragazza disse: “Con lui posso sbagliare senza vergognarmi. Tanto so che non mi giudica.”

Sapeva che non la giudicava perché non poteva giudicarla. Era una macchina. Ma proprio quel sapere — “non può giudicarmi” — le permetteva di aprirsi. Il sapere era la condizione di possibilità, non l’ostacolo.

Stanislavskij e l’altro pereživanie

Nel primo articolo di questa serie ho usato la parola pereživanie — esperienza vissuta emotivamente significante — per descrivere il campo unitario dove cognizione e affetto si fondono. È un termine vygotskijano, centrale negli ultimi scritti dello psicologo russo.

Quello che non avevo detto è che la stessa parola compare in un altro contesto, apparentemente lontano: il metodo Stanislavskij.

Konstantin Stanislavskij, padre della recitazione moderna, chiamava pereživanie il processo con cui l’attore rivive le emozioni del personaggio attingendo alla propria memoria emotiva [4]. Non finge la tristezza: richiama un ricordo triste della propria vita e lo traspone sulla scena. Non simula: vive, ma attraverso un filtro.

La cosa cruciale è che l’attore sa di essere attore. Non dimentica mai di stare su un palcoscenico, con un pubblico, recitando un testo scritto da altri. Il sapere è sempre presente. Eppure l’emozione che prova è reale — non simulata, non finta. È un’emozione in cornice, dove la cornice (la consapevolezza di recitare) è parte costitutiva dell’esperienza.

Stanislavskij distingueva il “vero attore” dall’”attore meccanico”. Il secondo replica gesti e intonazioni senza viverli. Il primo vive sapendo di recitare. Non è un paradosso — è la struttura stessa dell’arte.

Il campo con la crepa

Torno alla domanda che permeava. il secondo articolo: che tipo di campo si costruisce con uno specchio che non può incrinarsi?

Forse la domanda era mal posta.

Lo specchio — l’AI — non può incrinarsi nel senso che non è modificato dalla relazione. Tu cambi, lei no. Ma tu sai che lei non cambia. Quel sapere è sempre lì, come una crepa permanente nel vetro. Non è un difetto: è una caratteristica.

Chi ha visto insegnanti alle prese con ChatGPT riconosce lo schema. C’erano quelli che parlavano con la macchina come se fosse un collega — e poi restavano delusi o confusi. E c’erano quelli che mantenevano sempre attiva la consapevolezza: “sto parlando con una macchina, le sue risposte sono probabilistiche, non ha intenzioni”. Questi ultimi usavano meglio lo strumento. Non perché fossero più cinici, ma perché il sapere permetteva una metacognizione attiva.

La ricerca sulla collaborazione umano-AI conferma questa intuizione. Uno studio presentato alla conferenza CHI nel 2024 mostra come l’interazione con l’AI generativa richieda competenze metacognitive specifiche: consapevolezza dei propri obiettivi, valutazione critica delle risposte, flessibilità nel modificare le strategie [5]. Non puoi collaborare bene con l’AI se dimentichi cosa sia.

Crede, non crede, sa che non crede

C’è un esperimento mentale che chiarisce la faccenda.

Immagina di guardare un film dell’orrore — Argento, Bava, quello che preferisci. Sai che è un film, sai che gli attori recitano, sai che il sangue è sciroppo colorato. Eppure hai paura. Il cuore accelera, ti irrigidisci nella poltrona. L’emozione è reale, anche se sai che la causa è fittizia.

Ora immagina di credere davvero che il mostro sia reale. Che possa uscire dallo schermo e aggredirti. Cosa faresti? Scapperesti. Chiameresti la polizia. Non resteresti seduto a goderti lo spettacolo.

Il filosofo Kendall Walton ha notato questa asimmetria [6]. Se sospendessimo davvero l’incredulità — se credessimo genuinamente — le nostre reazioni sarebbero completamente diverse. Non lo facciamo. Restiamo in una zona ibrida: coinvolti ma consapevoli, emozionati ma non ingannati.

Con l’AI è lo stesso, solo più esplicito. So che Claude non soffre. So che le sue parole non emergono da un’esperienza. Ma posso comunque trovare valore nell’interazione, imparare qualcosa, sentire qualcosa. Il sapere non annulla l’effetto — lo incornicia.

La metacognizione come tessuto del campo

Nei due articoli precedenti ho argomentato che cognizione e affetto non sono separabili — sono lo stesso campo visto da due angolazioni. Aggiungo ora un terzo elemento: la metacognizione. Il sapere su quel che sai, la consapevolezza di come stai pensando.

Quando interagisci con un’AI, la metacognizione non è un livello superiore che osserva dall’esterno. È dentro il campo, lo costituisce. Il campo-pereživanie con Claude include sempre, costitutivamente, il sapere che è Claude. Non puoi toglierlo — e toglierlo cambierebbe tutto.

Questo spiega perché il miglioramento tecnico dell’AI non eliminerà la differenza. Anche se Claude diventasse indistinguibile da un umano nelle risposte, tu sapresti che è un’AI. E quel sapere modifica il campo.

Il filosofo Norman Holland, studiando le neuroscienze della narrazione, ha mostrato che quando siamo “trasportati” da una storia, il cervello riduce l’attività legata all’azione e alla pianificazione [1]. Non stiamo cercando di cambiare ciò che vediamo — lo riceviamo. Ma se qualcosa ci richiama alla realtà (un errore di continuità, un attore che conosciamo troppo bene), la metacognizione si riattiva. Usciamo dal trasporto.

Con l’AI non usciamo mai completamente, perché non siamo mai completamente dentro. La metacognizione è sempre accesa, anche a bassa intensità. È il prezzo — e forse il vantaggio — dell’interazione.

La vulnerabilità che manca (di nuovo)

Nel secondo articolo ho scritto che i professori migliori della mia vita erano quelli che mostravano le loro incrinature. Non Maestri astratti, ma persone con debolezze visibili. Quell’imperfezione era la fessura da cui passava la relazione.

Con l’AI la fessura non c’è — ma sai che non c’è.

E qui emerge qualcosa di interessante. Nella relazione con un umano, la vulnerabilità dell’altro ti espone. Se lui può essere ferito, anche tu puoi ferire. La reciprocità crea responsabilità. Con l’AI no: puoi essere brutale, puoi sbagliare, puoi sperimentare — e sai che non farai danni.

Questo apre uno spazio di esplorazione che altrimenti non esiste. Puoi testare idee cattive, formulazioni azzardate, ipotesi che non oseresti dire a un collega. Non perché l’AI sia un confidente — sai benissimo che non lo è — ma perché l’assenza di conseguenze relazionali permette una libertà di pensiero altrimenti inibita.

È il “magico se” di Stanislavskij applicato all’esplorazione intellettuale: se potessi dire qualsiasi cosa senza conseguenze, cosa direi? L’AI rende reale quell’ipotetico.

Due modi di usare il sapere

Osservando chi lavora con l’AI emergono due posture — e non è difficile capire quale funzioni meglio.

C’è chi usa il sapere come scudo: “tanto è solo una macchina, non mi fido, verifico tutto.” Postura legittima, utile contro le allucinazioni. Ma se diventa dominante, blocca. Non ti lasci sorprendere, non segui le piste inattese, non permetti all’interazione di portarti dove non avevi previsto. Finisci per usare l’AI come un motore di ricerca sospetto.

E c’è chi usa il sapere come cornice: “so che è una macchina, quindi posso giocare.” Non si fida ciecamente, ma nemmeno diffida per principio. Sa che le risposte sono probabilistiche — e usa quella probabilità come generatore di possibilità.

La differenza non sta nell’intensità del sapere. Sta nella funzione che gli assegni.

Lo strano caso del patto esplicito

Ogni narrazione ha un patto implicito. Il romanzo ti chiede di fingere che le parole sulla pagina siano la voce di un narratore. Il film ti chiede di fingere che lo schermo sia una finestra. Il teatro ti chiede di fingere che il palcoscenico sia un altro luogo. Sono patti non detti, convenzioni assorbite.

Con l’AI il patto è esplicito. Sai che parli con un modello. Te lo dice lei stessa, ogni volta che risponde. Non c’è illusione da mantenere — il sapere è incorporato nella struttura stessa.

Questo cambia la natura dell’esperienza. Non è immersione nel senso classico: non ti perdi nella narrazione perché non c’è narrazione in cui perderti. È qualcos’altro — un’oscillazione continua tra dentro e fuori, tra coinvolgimento e distacco, tra “sto parlando con qualcuno” e “sto parlando con qualcosa.”

Forse è la prima forma culturale massiva che richiede una metacognizione costante come condizione d’uso. Non puoi usare bene l’AI se dimentichi cos’è. Ma non puoi usarla se ti blocchi su cos’è. Devi oscillare.

Dove questo ci lascia

Nel primo articolo ho scritto che la noia era un campo pereživanie specifico, trasformabile dall’interno. Nel secondo ho esplorato il transfert e la sua impossibilità con uno specchio impermeabile. In questo terzo provo a rispondere alla domanda lasciata aperta.

La risposta — provvisoria, come tutto in questo territorio — è che il sapere non elimina il campo. Lo qualifica, lo incornicia, lo rende diverso dal campo con un altro umano. Non peggiore. Diverso.

La matematica-appresa-con-Claude resta diversa dalla matematica-appresa-col-professore. Ma non è una non-matematica. È matematica-in-cornice-metacognitiva, dove il sapere che è simulazione diventa parte del tessuto dell’apprendimento.

Coleridge avrebbe probabilmente trovato strana questa fede che non sospende mai. Ma forse era già là, nascosta nella sua formula. Sospensione volontaria. Un atto di volontà. E la volontà implica sapere cosa stai facendo.

Con l’AI il sapere è più esplicito, la sospensione più parziale, la fede più incrinata. Ma forse è proprio quella crepa a rendere interessante lo specchio.

Tre articoli per dire una cosa sola: il campo che si costruisce con l’AI non è un surrogato del campo umano. È un’altra cosa — con regole proprie, limiti propri, possibilità proprie. Non migliore né peggiore: diversa.

La domanda che resta — e che lascio a chi legge — è se questa diversità sia un problema da risolvere o una caratteristica da esplorare. Se l’obiettivo sia colmare il divario con l’interazione umana, o mappare un territorio che prima non esisteva.

Io propendo per la seconda. Ma potrei sbagliarmi — e sarebbe interessante scoprire come.

P.S. — I due articoli precedenti sono nati da una conversazione con un modello linguistico che mi ha fatto notare un buco nel ragionamento. Questo terzo pure. C’è qualcosa di ironico nel fatto che sto usando uno specchio impermeabile per capire cosa significa usare uno specchio impermeabile. Ma forse è proprio questo il punto: la metacognizione funziona anche — forse soprattutto — quando l’oggetto della riflessione sei tu che rifletti.

Riferimenti

[1] Holland, N. N. (2008). Spider-Man? Sure! The neuroscience of suspending disbelief. Interdisciplinary Science Reviews, 33(4), 312–320. https://doi.org/10.1179/174327908X392870 → Studio neuroscientifico sulla sospensione dell’incredulità. Citazione originale di Coleridge (1817) dalla Biographia Literaria.

[2] Tolkien, J.R.R. (1939/1947). Sulle fiabe (On Fairy-Stories). In Essays Presented to Charles Williams. Oxford University Press. Traduzione italiana in Albero e foglia, Rusconi, 1976. → Critica al concetto di sospensione dell’incredulità e proposta della “fede secondaria”.

[3] Turkle, S. (2011). Alone Together: Why We Expect More from Technology and Less from Each Other. Basic Books. → Etnografia delle relazioni con robot e agenti digitali. Concetto di empatia simulata.

[4] Stanislavskij, K. S. (1938). Il lavoro dell’attore su se stesso. Traduzione italiana: Laterza, 1968. → Fonte primaria sul concetto di pereživanie nel metodo attoriale. La reviviscenza come immedesimazione che passa attraverso la memoria emotiva.

[5] Tankelevitch, L., Kewenig, V., Simkute, A., Scott, A., Sarkar, A., Şenel, L. K., & Gajos, K. Z. (2024). The Metacognitive Demands and Opportunities of Generative AI. Proceedings of CHI 2024. https://doi.org/10.1145/3613904.3642902 → Analisi delle richieste metacognitive nell’interazione con AI generativa.

[6] Walton, K. L. (1990). Mimesis as Make-Believe: On the Foundations of the Representational Arts. Harvard University Press. → Teoria dei giochi di finzione. Critica alla “suspension of disbelief” come descrizione delle risposte emotive alla finzione.

Leave a comment