Quando la Compressione Semantica Incontra l’Archivio Intelligente

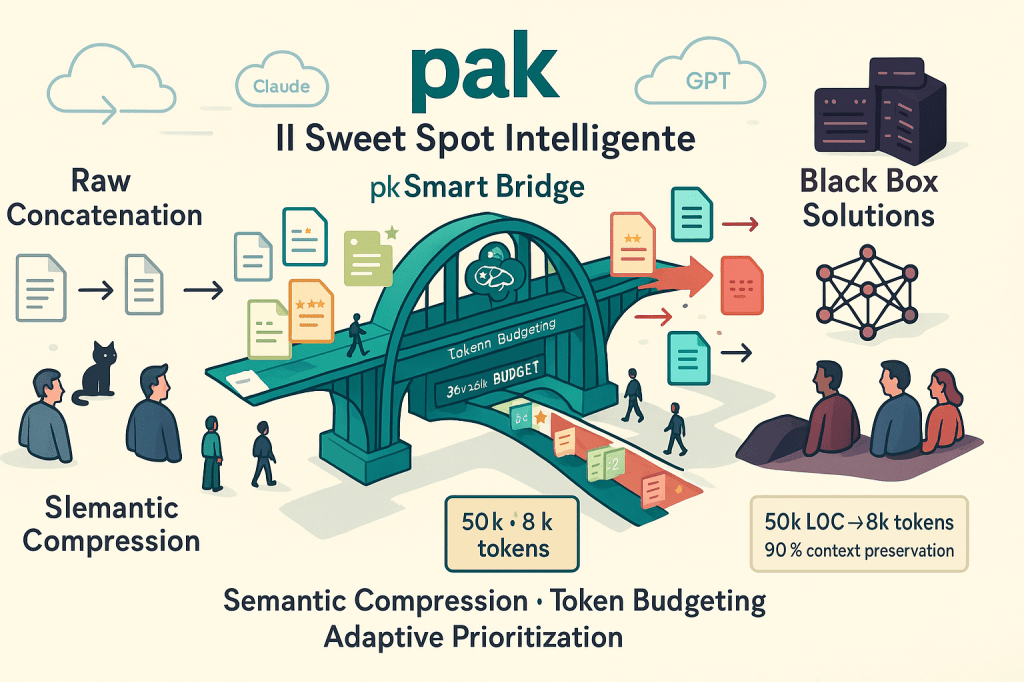

Il mercato degli strumenti per preparare codice destinato ai Large Language Model è in piena effervescenza. Tra concatenatori naïf, compressori aggressivi e soluzioni enterprise, pak si posiziona come una sintesi intelligente che merita un confronto approfondito con i competitor esistenti.

L’Ecosistema Attuale: Chi Fa Cosa

I “Concatenatori Semplici”

Simon Willison’s files-to-prompt [1] rappresenta l’approccio diretto: un tool Python che concatena file rispettando .gitignore, con filtri per estensioni e pattern di esclusione. La filosofia è “less is more” – niente compressione, massima trasparenza.

Punti di forza: semplicità cristallina, output predicibile, integrazione perfetta con l’ecosistema llm di Willison.

Limitazioni: nessuna ottimizzazione token, rischio di overwhelm del context window con progetti di media grandezza.

I “Repository Digesters”

Gitingest [2][3] e le sue numerose varianti (Python, Ruby, Go) offrono la conversione “one-click” da repository GitHub a digest testuale. L’idea centrale è brillante nella sua immediatezza: cambia github.com in gitingest.com nell’URL e ottieni un file di testo pronto per l’LLM.

Repomix [4] aggiunge metadati strutturati, conteggio token e un format XML che strizza l’occhio alle preferenze di Claude. Include anche security scanning per evitare leak di credenziali.

Vantaggi: accesso immediato a qualsiasi repo pubblico, formato standardizzato.

Limiti: zero personalizzazione della compressione, approccio “one-size-fits-all” che non distingue tra file critici e accessori.

I “Context Optimizers”

llm-context.py [5] e code-context-llm [6] introducono il concetto di smart outlining – generano prima una mappa strutturale del progetto, poi permettono l’estrazione selettiva delle implementazioni richieste dall’LLM.

LLMLingua [7] dal mondo accademico applica tecniche di prompt compression usando modelli dedicati per identificare e rimuovere token ridondanti.

Approccio sofisticato: compressione guidata da modelli neurali, risultati quantificabili.

Complessità: setup più elaborato, dipendenze aggiuntive, meno controllo diretto sul processo.

Dove si Posiziona Pak

La Filosofia del “Semantic Aware Archiver”

Pak non è un semplice concatenatore né un compressore cieco. È un archivio semantico che comprende la natura gerarchica e l’importanza relativa dei file in un progetto software.

La distinzione cruciale: mentre gli altri tool trattano tutti i file equivalentemente, pak introduce il concetto di prioritizzazione intelligente combinato con compressione adattiva.

Il Vantaggio della Modalità Smart

pak --compress-level smart --max-tokens 16000 ./my_project > context.pak

Questo comando attiva un processo decisionale che:

- Classifica i file per importanza semantica (README > main.py > test.py)

- Calcola il budget token disponibile

- Applica livelli di compressione differenziati per rispettare il limite

- Preserva i file critici applicando compressione aggressiva a quelli secondari

Nessun altro tool nel panorama attuale offre questa combinazione di token budgeting e semantic prioritization.

La Gestione dei Metadati

Il formato di pak include informazioni che gli altri tool ignorano:

Path: src/api/models.py

Language: python

Size: 3247

Lines: 89

Tokens: 723

Compression: aggressive

Method: text-based

Questi metadati non sono decorativi – permettono all’LLM di contestualizzare meglio ogni file e al developer di capire cosa è stato compresso e quanto.

Confronto Tecnico Dettagliato

Gestione dei Token

| Tool | Token Counting | Budget Limit | Adaptive Compression |

|---|---|---|---|

| files-to-prompt | ❌ | ❌ | ❌ |

| Gitingest | ✅ | ❌ | ❌ |

| Repomix | ✅ | ❌ | ❌ |

| llm-context.py | ✅ | ⚠️ (manual) | ⚠️ (outlining) |

| pak | ✅ | ✅ | ✅ |

Livelli di Compressione

pak è l’unico a offrire una scala graduata:

none: archivio puro senza compressionelight: rimozione whitespace e formattazionemedium: eliminazione commenti e import ridondantiaggressive: estrazione solo delle strutture essenzialismart: compressione adattiva basata su priorità e budget

Gli altri tool sono binari: tutto o niente, senza sfumature.

Filtering e Esclusioni

pak integra SEMANTIC_EXCLUDES – una lista curata di pattern che esclude automaticamente:

- Build artifacts (

*.min.js,dist/*,build/*) - Dependency directories (

node_modules/*,vendor/*) - Development cruft (

*.log,*cache*,.DS_Store) - Binary files e media

Questa intelligence è il risultato di esperienza pratica, non di pattern generici.

Caso di Studio: Progetto Django Reale

Prendiamo un progetto Django tipico (15k LOC, 200 file):

files-to-prompt

files-to-prompt ./django_project > output.txt

# Risultato: 892k token, overwhelming per qualsiasi LLM

Gitingest

# Via web: github.com → gitingest.com

# Risultato: 654k token, ancora troppo, zero controllo

pak (modalità smart)

pak --compress-level smart --max-tokens 32000 ./django_project > context.pak

# Risultato: 31.8k token, perfettamente utilizzabile

Il processo di pak:

- Identifica

models.py,views.py,urls.pycome file critici - Applica compressione

lightai file core - Compressione

mediumai file di supporto - Compressione

aggressiveai test - Esclude completamente file di fixture e mock se necessario

Risultato: l’LLM riceve il 90% dell’informazione architetturale e solo il 5% dei token originali.

I Punti di Forza Distintivi

1. Intelligenza Contestuale

pak sa che README.md è più importante di test_utils.py. Questa knowledge non è hardcoded ma deriva da pattern riconosciuti nell’ecosistema software reale.

2. Trasparenza Operativa

Il formato .pak è ispezionabile. Puoi aprirlo, vedere cosa è stato compresso e come, modificarlo se necessario. Niente black box.

3. Workflow Integration

pak si integra naturalmente nei workflow di development:

# Durante code review

pak --compress-level light ./feature_branch > review.pak

# Per context handoff

pak --compress-level smart --max-tokens 24000 ./legacy_project > handoff.pak

# Per debugging assisted

pak --compress-level medium --ext .py ./problematic_module > debug.pak

4. Reversibilità

Comando --unpack per estrarre l’archivio e ricostruire la struttura originale. Gli altri tool sono “write-only”.

Le Limitazioni Oneste

1. Complessità vs Semplicità

pak richiede decisioni: quale livello di compressione? Che budget token? files-to-prompt è più immediato per use case semplici.

2. Dipendenze

Bash-based, ottimizzato per sistemi Unix. Non la scelta ideale per ambienti Windows puri o setup minimali.

3. Learning Curve

La modalità smart richiede comprensione del processo di prioritizzazione. Un nuovo utente potrebbe preferire l’approccio più diretto di Gitingest.

Scenari d’Uso Ottimali

pak eccelle quando hai:

- Progetti multi-file complessi che superano il context window

- Need di token budgeting preciso per rispettare limiti di costo/performance

- Workflow iterativi dove serve compressione personalizzabile

- Code review assisted dove serve focus su architettura vs implementazione

pak non è ideale per:

- Quick & dirty analysis di repo sconosciuti (meglio Gitingest)

- Single file o progetti minuscoli (overkill)

- Ambienti dove la semplicità è prioritaria rispetto all’ottimizzazione

Considerazioni sull’Evoluzione del Mercato

Il panorama degli strumenti di context preparation sta rapidamente evolvendo. Claude Projects, Cursor’s @-commands e l’integrazione nativa nei IDE stanno cambiando le carte in tavola.

pak si posiziona come bridge tool – più sofisticato dei concatenatori semplici, più controllabile delle soluzioni black-box, più flessibile dei servizi cloud proprietari.

pak3 con AST support consente di ampliare ulteriormente il gap competitivo, introducendo compressione basata su comprensione sintattica reale piuttosto che pattern testuali.

Conclusione

In un ecosistema di strumenti che tendono verso i due estremi – semplicità estrema o complessità accademica – pak occupa il sweet spot dell’intelligenza pratica.

Non è il tool più veloce da imparare, ma è quello che cresce con le tue esigenze. Non è il più semplice da usare, ma è quello che rispetta la tua intelligence invece di sostituirla.

Per developer che prendono sul serio l’integrazione degli LLM nel loro workflow, pak rappresenta un investimento che paga dividendi crescenti man mano che i progetti diventano più complessi e i context budget più stringenti.

La vera differenza non sta nelle feature, ma nella filosofia: pak non vuole essere invisibile, vuole essere intelligentemente utile.

Riferimenti

[0] https://github.com/pakkio/pak

[1] https://github.com/simonw/files-to-prompt

[2] https://github.com/cyclotruc/gitingest

[4] https://github.com/yamadashy/repomix

[5] https://github.com/cyberchitta/llm-context.py

[6] https://github.com/nt9142/code-context-llm

[7] https://github.com/HuangOwen/Awesome-LLM-Compression

[8] https://simonwillison.net/2025/Mar/11/using-llms-for-code/

[9] https://workos.com/blog/context-is-king-tools-for-feeding-your-code-and-website-to-llms

[10] https://www.docker.com/blog/using-docker-ai-tools-for-devs-to-provide-context-for-better-code-fixes/

Leave a comment