Introduzione

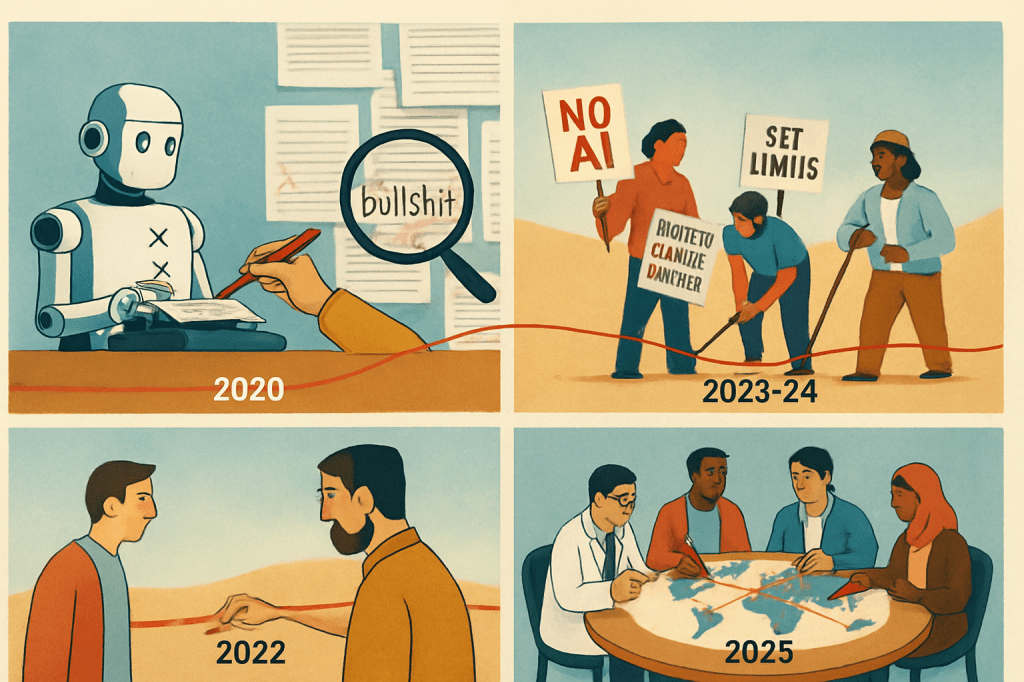

Negli ultimi cinque anni, l’intelligenza artificiale generativa ha compiuto una metamorfosi straordinaria, trasformandosi da tecnologia sperimentale a strumento onnipresente. Questo articolo ripercorre l’evoluzione della critica a questi sistemi, evidenziando come il dibattito si sia progressivamente spostato dalle mere capacità tecniche verso implicazioni più profonde, di natura sociale, economica e culturale. L’analisi si basa esclusivamente su fonti verificabili e dati concreti, evitando previsioni speculative o affermazioni non supportate.

2020: La critica dei “fallimenti specifici”

Il primo stadio della critica all’AI generativa si concentrava principalmente sui limiti tecnici. Quando OpenAI rilasciò GPT-3, Gary Marcus ed Ernest Davis pubblicarono su MIT Technology Review un’analisi critica intitolata “GPT-3, Bloviator: OpenAI’s language generator has no idea what it’s talking about” [1].

Gli autori evidenziavano carenze fondamentali del modello attraverso esempi concreti:

- Ragionamento biologico incoerente: GPT-3 considerava mortale la miscela di succo di mirtillo e succo d’uva

- Ragionamento fisico assurdo: proponeva di segare una porta a metà per far passare un tavolo

- Ragionamento sociale inappropriato: suggeriva a un avvocato di indossare un costume da bagno in tribunale

Marcus e Davis argomentavano che, nonostante la fluenza linguistica impressionante, GPT-3 mancava di una vera comprensione del mondo. “Non impara mai nulla sul mondo brulicante e ronzante là fuori. Impara correlazioni tra parole, e niente più“, scrivevano, toccando quello che sarebbe diventato un tema ricorrente della critica ai modelli generativi.

Questa prima fase era caratterizzata da:

- Focus sui limiti tecnici specifici

- Analisi dei fallimenti concreti in compiti di ragionamento

- Scetticismo verso le affermazioni più entusiastiche riguardo le capacità di “comprensione” dell’AI

2022: La critica delle “limitazioni intrinseche”

Con il rilascio di ChatGPT alla fine del 2022, il dibattito si spostò a un livello più profondo. In un articolo su The Atlantic intitolato “ChatGPT Is Dumber Than You Think” [2], Ian Bogost propose una critica più sofisticata, non più concentrata su errori specifici ma sulla natura stessa dei modelli linguistici.

Bogost definì ChatGPT un “superbo bullshitter” – un termine che coglieva perfettamente la capacità del sistema di produrre testo plausibile ma spesso privo di sostanza. La sua analisi spostava l’attenzione dalle capacità tecniche alle questioni epistemologiche.

“I modelli linguistici di grandi dimensioni sono strumenti estetici piuttosto che epistemologici. Immagina un sintetizzatore strano e profano i cui pulsanti campionano informazioni testuali, stile e semantica.”

Bogost identificò anche un paradosso fondamentale: “Se già si deve possedere l’expertise per identificare i problemi nel testo generato dall’AI, ma lo scopo del testo generato dall’AI è proprio quello di eliminare la necessità di tale conoscenza, allora ci troviamo davvero in un bel pasticcio.” Questa osservazione anticipava il dibattito sulla qualità dell’informazione nell’era dell’AI generativa.

Questa seconda fase della critica era caratterizzata da:

- Attenzione alla natura dei modelli linguistici

- Preoccupazione per un potenziale appiattimento linguistico e culturale

- Riflessione sulle implicazioni per la qualità dell’informazione

2023-2024: La critica della “resistenza organizzata”

Nel biennio 2023-2024, il dibattito sull’AI generativa è uscito dalle riviste specializzate per entrare nell’arena sociale. Lo sciopero degli sceneggiatori di Hollywood ha rappresentato un momento cruciale in questo passaggio. Gli sceneggiatori non si sono opposti all’AI in quanto tale, ma all’uso che gli studios intendevano farne, tracciando una “linea rossa” contro l’utilizzo dell’AI per svalutare il lavoro creativo.

Questo ha portato a una rivalutazione del concetto di “luddismo”. Contrariamente all’uso comune dispregiativo del termine (“luddista” come sinonimo di “tecnofobico”), è emerso un luddismo informato e consapevole: non un’opposizione irrazionale al progresso tecnologico, ma una resistenza specifica a implementazioni dannose della tecnologia.

I Luddisti originali del 1811-1816 non erano nemici irrazionali del progresso, ma artigiani qualificati che protestavano contro l’uso di telai meccanici specificamente progettati per degradare la qualità del prodotto e abbassare le retribuzioni. In modo analogo, gli sceneggiatori non rifiutavano l’AI in sé, ma il suo utilizzo per degradare il lavoro creativo.

Questa terza fase della critica era caratterizzata da:

- Azione collettiva contro usi potenzialmente dannosi dell’AI

- Distinzione cruciale tra tecnologia e suoi utilizzi specifici

- Richiesta di governance partecipativa dell’innovazione tecnologica

2025: La fase della “governance responsabile”

Nel 2025, il dibattito sull’AI generativa si è ulteriormente evoluto verso questioni di governance, etica e integrazione responsabile. Come riportato dal Sole 24 Ore nell’AI Index 2025, il costo per prestazioni equivalenti a GPT-3.5 è crollato di 280 volte tra novembre 2022 e ottobre 2024, rendendo questa tecnologia sempre più accessibile e pervasiva.

Questa democratizzazione ha portato a nuove preoccupazioni. AI4Business ha catalogato i “maggiori fiaschi dell’AI nel 2024”, documentando casi di chatbot che forniscono consigli illegali o inappropriati, evidenziando come la tecnologia, nonostante i progressi, continui a presentare limiti significativi.

Tra i “fiaschi” documentati vi sono:

- L’invasione di contenuti generati dall’AI in ogni angolo di Internet, con conseguente aumento di materiale di bassa qualità

- L’uso di immagini AI surreali che distorcono le aspettative sugli eventi reali

- L’emergere di strumenti come Grok che permettono di generare immagini con pochi guardrail etici

La fase attuale della critica è caratterizzata da:

- Attenzione ai rischi sistemici dell’AI generativa

- Focus sulla regolamentazione

- Dibattito sul divario tecnologico tra diversi attori

- Preoccupazioni per sicurezza informatica e nazionale

Oltre l’Occidente: prospettive globali sulla critica all’AI

Un limite significativo nel dibattito tracciato finora è la predominanza di voci occidentali, principalmente americane ed europee. Tuttavia, l’impatto dell’AI generativa è globale, e le prospettive dal Sud del mondo offrono angolazioni critiche fondamentali e spesso trascurate.

Nelle economie emergenti e nei paesi in via di sviluppo, la critica all’AI generativa si intreccia spesso con preoccupazioni relative a nuove forme di colonialismo tecnologico. I modelli di AI generativa vengono addestrati prevalentemente su dati provenienti dal Nord globale, perpetuando così visioni del mondo, valori e priorità occidentali.

Ricercatrici come Abeba Birhane e Timnit Gebru hanno evidenziato come questi modelli possano rafforzare gerarchie di potere esistenti, con i paesi del Sud globale ridotti a consumatori passivi di tecnologie sviluppate altrove, senza possibilità di influenzarne la direzione o adattarle ai contesti locali.

Un altro filone critico emergente riguarda il divario di accesso alle tecnologie di AI generativa e le preoccupazioni sulla diversità linguistica e culturale. Con la maggior parte dei modelli ottimizzati per l’inglese e altre lingue occidentali, emergono timori sulla marginalizzazione di lingue con minori risorse digitali.

Iniziative come Masakhane nell’Africa subsahariana rappresentano sforzi per sviluppare tecnologie di AI che rispettino e valorizzino la diversità linguistica e culturale locale.

Dalla “meraviglia tecnologica” al “realismo digitale”

Il percorso che abbiamo tracciato mostra una chiara evoluzione del dibattito critico: dalle preoccupazioni iniziali sui limiti tecnici si è passati a riflessioni più ampie sulla natura dei modelli, per poi arrivare a questioni di impatto sociale, lavorativo e culturale, fino alle attuali discussioni su governance e regolamentazione.

Questa evoluzione riflette anche un cambiamento di atteggiamento: dall’iniziale dicotomia tra entusiasti acritici e scettici totali, si è giunti a una posizione più sfumata che potremmo definire di “realismo digitale” – un approccio che riconosce sia le potenzialità che i limiti dell’AI generativa, cercando di indirizzarne lo sviluppo verso obiettivi socialmente desiderabili.

In questo contesto, il luddismo informato emerso durante lo sciopero degli sceneggiatori offre una preziosa bussola etica. Non si tratta di opporsi all’innovazione tecnologica in quanto tale, ma di rivendicare il diritto democratico di partecipare alle decisioni su come la tecnologia viene sviluppata e implementata.

Questo approccio permette di superare sia il determinismo tecnologico (“il progresso è inevitabile”) sia il rifiuto indiscriminato, offrendo invece un modello di innovazione tecnologica partecipativa in cui lavoratori, cittadini e comunità hanno voce in capitolo nel definire quali tecnologie adottare e come utilizzarle.

Conclusione

L’evoluzione della critica all’AI generativa dal 2020 al 2025 riflette non solo i progressi tecnologici, ma anche la maturazione della nostra comprensione sociale di questi strumenti. Le osservazioni tecniche di Marcus e Davis del 2020, lungi dall’essere “preistoriche”, contenevano intuizioni fondamentali sulla natura della comprensione artificiale che hanno continuato a informare il dibattito successivo.

L’eredità più importante di questo quinquennio di critica è forse proprio la riabilitazione dell’idea di “tracciare linee rosse” – non come atto di resistenza irrazionale al progresso, ma come esercizio necessario di autodeterminazione democratica di fronte a cambiamenti tecnologici radicali.

La sfida per il futuro sarà sviluppare meccanismi democratici per tracciare collettivamente queste linee rosse, garantendo che l’evoluzione dell’AI generativa avvenga in modo da amplificare – non sostituire – l’intelligenza, la creatività e l’autonomia umana.

Riferimenti:

[1] Marcus, G., & Davis, E. (2020). GPT-3, Bloviator: OpenAI’s language generator has no idea what it’s talking about. MIT Technology Review. https://www.technologyreview.com/2020/08/22/1007539/gpt3-openai-language-generator-artificial-intelligence-ai-opinion/

[2] Bogost, I. (2022). ChatGPT Is Dumber Than You Think. The Atlantic. https://www.theatlantic.com/technology/archive/2022/12/chatgpt-openai-artificial-intelligence-writing-ethics/672386/

[3] Il Sole 24 ORE. (2025). AI index 2025: la fotografia (pre-guerra commerciale) dell’intelligenza artificiale. https://www.infodata.ilsole24ore.com/2025/04/10/ai-index-2025/

[4] AI4Business. (2025). I maggiori “fiaschi” dell’AI nel 2024. https://www.ai4business.it/intelligenza-artificiale/i-maggiori-fiaschi-dellai-nel-2024/

Leave a comment